סוכן תבוני

בבינה מלאכותית, סוכן תבוני או IA (ראשי תיבות באנגלית של: Intelligent Agent) הוא כל דבר שתופס את סביבתו, נוקט פעולות באופן אוטונומי על מנת להשיג מטרות, ועשוי לשפר את ביצועיו עם למידה וכן עשוי להשתמש בידע. IA עשוי להיות פשוט או מורכב - תרמוסטט נחשב דוגמה לסוכן תבוני, כמו גם בן אדם, כמו גם כל מערכת העונה על ההגדרה, כגון חברה, מדינה או ביומה.[1]

ספרות אקדמית מובילה בתחום בינה מלאכותית מגדירה "בינה מלאכותית" כ"מחקר ועיצוב של סוכנים תבוניים", הגדרה הרואה בהתנהגות מכוונת-מטרה את מהות האינטליגנציה. סוכנים מכווני מטרה מתוארים גם באמצעות מונח השאול מכלכלה, "סוכן רציונלי".[1]

לסוכן יש "פונקציית מטרה" הכוללת את כל היעדים של היחידה. סוכן כזה נועד ליצור ולבצע תוכנית כלשהי שתביא בסיומה למקסם את הערך הצפוי של פונקציית המטרה.[2] לדוגמה, לסוכן למידת חיזוק יש "פונקציית תגמול" המאפשרת למפתחים לעצב את ההתנהגות הרצויה של ה-IA,[3] וכן התנהגותו של אלגוריתם אבולוציוני מעוצבת על ידי "פונקציית כושר".[4]

סוכנים תבוניים, בבינה מלאכותית קשורים קשר הדוק ל"סוכנים" מעולם הכלכלה, וגרסאות של פרדיגמת הסוכנים התבוניים נלמדות במדעי הקוגניציה, האתיקה, הפילוסופיה של התבונה המעשית, כמו גם במודלים סוציו-קוגניטיביים בינתחומיים רבים ובסימולציות חברתיות ממוחשבות.

סוכנים תבוניים מתוארים לעיתים קרובות באופן סכמטי כמערכת פונקציונלית מופשטת הדומה לתוכנית מחשב. תיאורים מופשטים של סוכנים תבוניים נקראים סוכנים תבוניים מופשטים (AIA) כדי להבדיל אותם מהמימושים בעולם האמיתי שלהם. סוכן תבוני אוטונומי נועד לתפקד בהיעדר התערבות אנושית מכלשהי. סוכנים תבוניים קשורים קשר הדוק גם לסוכני תוכנה (תוכנת מחשב אוטונומית המבצעת משימות בשם המשתמשים).

הגדרה של בינה מלאכותית[עריכת קוד מקור | עריכה]

מדעי המחשב מגדירים מחקר בינה מלאכותית כמחקר של סוכנים חכמים. [lower-alpha 1] ספר הלימוד המוביל בינה מלאכותית[5][6] מגדיר "סוכן" כ:

- "כל דבר שניתן לראות כתופס את סביבתו באמצעות חיישנים ופועל על הסביבה באמצעות מפעילים (actuators)"

מגדיר "סוכן רציונלי" כ:

- "סוכן שפועל כדי למקסם את הערך הצפוי של מדד ביצועים בהתבסס על ניסיון וידע צבור."

ומגדיר את תחום המחקר של "בינה מלאכותית" כ:

- "המחקר והעיצוב של סוכנים רציונליים"

הגדרה דומה של AI ניתנת על ידי קפלן והאנליין: "היכולת של מערכת לפרש נכון נתונים חיצוניים, ללמוד מנתונים כאלה ולהשתמש בלמידה זו כדי להשיג מטרות ומשימות ספציפיות באמצעות התאמה גמישה".[7]

פדגם וויניקוף (Padgham & Winikoff 2005) מסכימים שסוכן תבוני ממוקם בסביבה ומגיב (בזמן, אם כי לא בהכרח בזמן אמת) לשינויים בסביבה. עם זאת, סוכנים תבוניים חייבים גם לרדוף באופן יזום אחר יעדים בצורה גמישה וחזקה. [lower-alpha 2] כללים אופציונליים כוללים שהסוכן יהיה רציונלי ושהסוכן יהיה בעל יכולת ניתוח של "אמונה-רצון-כוונה".[8]

היתרונות של הגדרה זו[עריכת קוד מקור | עריכה]

מבחינה פילוסופית, הגדרה זו נמנעת מכמה שורות של ביקורת. בניגוד למבחן טיורינג, הוא אינו מתייחס לאינטליגנציה אנושית בשום צורה. לפיכך אין צורך לדון אם היא אינטליגנציה "אמיתית" לעומת "מדמה" (כלומר, אינטליגנציה "סינתטית" לעומת "מלאכותית"), ואינה מעידה על כך שלמכונה כזו יש שכל, תודעה או הבנה אמיתית (כלומר, זה לא מרמז על " השערת הבינה המלאכותית החזקה" של ג'ון סירל). זה גם לא מנסה למתוח קו הפרדה חד בין התנהגויות שהן "תבוניות" לבין התנהגויות שהן "לא תבוניות" - תוכניות צריכות להימדד רק במונחים של תפקודן האובייקטיבי.

חשוב מכך, יש לו מספר יתרונות מעשיים שעזרו לקדם את מחקר הבינה המלאכותית. הוא מספק דרך אמינה ומדעית לבדיקת תוכניות; חוקרים יכולים להשוות באופן ישיר או אפילו לשלב גישות שונות לבעיות בודדות, על ידי שאילת הגורם הטוב ביותר במקסום "פונקציית מטרה" נתונה. זה גם נותן להם שפה משותפת לתקשר עם תחומים אחרים - כמו אופטימיזציה מתמטית (שמוגדרת במונחים של "מטרות") או כלכלה (המשתמשת באותה הגדרה של "סוכן רציונלי").[9]

פונקציית מטרה[עריכת קוד מקור | עריכה]

סוכן שמוקצה לו "פונקציית מטרה" מפורשת נחשב לתבוניי יותר אם הוא נוקט בעקביות פעולות המצליחות לשפר ובפרט למקסם את פונקציית המטרה המתוכנתת שלו. המטרה יכולה להיות פשוטה ("1 אם ה-IA ינצח במשחק של Go,או 0 אחרת") או מורכבת ("בצע פעולות דומות מתמטית לאלו שהצליחו בעבר"). "פונקציית המטרה" מכילה את כל המטרות שהסוכן מונע לפעול לפיהן; במקרה של סוכנים תבוניים, הפונקציה מכילה גם את "שיקול הדעת" המקובל בין השגת מטרות סותרות הסותרות זו לזו. (הטרמינולוגיה משתנה; לדוגמה, סוכנים מסוימים מבקשים למקסם או למזער " פונקציית התועלת", "פונקציית מטרה" או "פונקציית הפסד".)[6]

ניתן להגדיר במפורש מטרות. אם ה-AI מתוכנת ל"לימוד חיזוק ", יש לו "פונקציית תגמול" המעודדת סוגים מסוימים של התנהגות ו"מענישה" אחרים. לחלופין, מערכת אבולוציונית יכולה ליצור מטרות על ידי שימוש ב"פונקציית כושר" כדי לבצע מוטציה ושכפול מועדף של מערכות בינה מלאכותית בעלות ניקוד גבוה, בדומה לאופן שבו בעלי חיים התפתחו לרצונות מלידה במטרות מסוימות כמו מציאת מזון.[10] מערכות בינה מלאכותיות מסוימות, כגון השכן הקרוב ביותר, במקום סיבה באנלוגיה, למערכות אלו אין בדרך כלל יעדים, אלא אם המטרות משתמעות בנתוני האימון שלהן.[11] עדיין ניתן למדוד מערכות כאלה אם המערכת ללא-מטרה ממוסגרת כמערכת ש"מטרתה" היא לבצע את משימת הסיווג המצומצמת שלה.[12]

מערכות שאינן נחשבות באופן מסורתי לסוכנים, כגון מערכות ייצוג ידע, נכללות לעיתים בפרדיגמה על ידי מסגורן כסוכנים שמטרתם (למשל) לענות על שאלות בצורה מדויקת ככל האפשר; המושג "פעולה" מורחב כאן כך שיכלול את ה"מעשה" של מתן תשובה לשאלה. כהרחבה נוספת, ניתן למסגר מערכות מונעות מימיקה כסוכנים אשר מייעלים "פונקציית מטרה" על סמך עד כמה ה-IA מצליח לחקות את ההתנהגות הרצויה.[6] ברשתות הג'נרטיביות של שנות ה-2010, רכיב "מקודד"/"מחולל" מנסה לחקות ולאלתר חיבור טקסט אנושי. המחולל מנסה למקסם פונקציה המנקדת עד כמה הוא יכול לשטות ברכיב "מנבא"/"אבחנה" אנטגוניסטי.[13]

סווגים של סוכנים תבוניים[עריכת קוד מקור | עריכה]

הסיווג של ראסל ונורוויג[עריכת קוד מקור | עריכה]

ראסל ונורוויג (2003) קיבצו סוכנים ל-5 מחלקות בהתבסס על רמת יכולת התפיסה שלהם והיכולות של:[14]

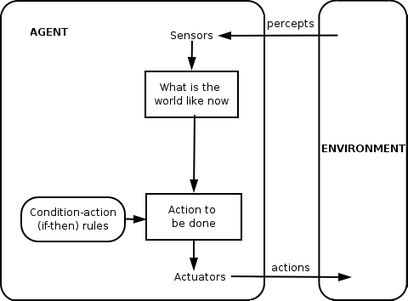

סוכן רפלקס פשוט[עריכת קוד מקור | עריכה]

סוכני רפלקס פשוטים פועלים רק על בסיס התפיסה הנוכחית, ומתעלמים משאר היסטוריית התפיסה. פונקציית הסוכן מבוססת על כלל תנאי-פעולה: "אם תנאי, אז פעולה".

פונקציית סוכן זו מצליחה רק כאשר הסביבה ניתנת לצפייה מלאה. סוכני רפלקס מסוימים יכולים גם להכיל מידע על מצבם הנוכחי המאפשר להם להתעלם מתנאים שהמפעילים שלהם כבר מופעלים.

לולאות אינסופיות הן לרוב בלתי נמנעות עבור סוכני רפלקס פשוטים הפועלים בסביבות הניתנות לצפייה חלקית. הערה: אם הסוכן יכול לעשות את פעולותיו באופן אקראי, ייתכן שיהיה אפשר להימנע מלולאות אינסופיות.

סוכני רפלקס מבוססי מודל[עריכת קוד מקור | עריכה]

סוכן מבוסס מודל יכול להתמודד עם סביבות הניתנות לצפייה חלקית. המצב הנוכחי שלו מאוחסן בתוך הסוכן תוך שמירה על מבנה כלשהו שמתאר את החלק של העולם שלא ניתן "לראות". הידע הזה על "איך העולם עובד" נקרא מודל של העולם, ומכאן השם "סוכן מבוסס מודל".

סוכן רפלקס מבוסס מודל צריך לשמור על מודל פנימי כלשהו שתלוי בהיסטוריה של התפיסה ובכך משקף לפחות חלק מההיבטים הלא נצפים של המצב הנוכחי. ניתן לקבוע היסטוריית תפיסה והשפעה של פעולה על הסביבה באמצעות המודל הפנימי. לאחר מכן הוא בוחר פעולה באותו אופן כמו סוכן רפלקס.

סוכן עשוי גם להשתמש במודלים כדי לתאר ולחזות התנהגויות של סוכנים אחרים בסביבה.[15]

סוכן מבוסס מטרה[עריכת קוד מקור | עריכה]

סוכנים מבוססי מטרה מרחיבים עוד יותר את היכולות של הסוכנים מבוססי המודל, על ידי שימוש במידע "מטרה". מידע יעד מתאר מצבים רצויים. זה מספק לסוכן דרך לבחור בין מספר אפשרויות, לבחור את זו שמגיעה למצב יעד. חיפוש ותכנון הם תת-התחומים של בינה מלאכותית המוקדשים למציאת רצפי פעולה המשיגים את מטרות הסוכן.

סוכנים מבוססי שירות[עריכת קוד מקור | עריכה]

סוכנים מבוססי מטרה מבחינים רק בין מצבי מטרה ומצבים ללא מטרה. אפשר גם להגדיר מדד למישקול של מצב מסוים. מדד זה יכול להתקבל באמצעות שימוש בפונקציית תועלת אשר ממפה מצב למדד של התועלת של המצב. מדד ביצועים כללי יותר אמור לאפשר השוואה בין מצבי העולם השונות לפי עד כמה הן עמדו במטרות הסוכן. ניתן להשתמש במונח עזר כדי לתאר עד כמה הסוכן "מאושר".

סוכן מבוסס תועלת תבוני בוחר את הפעולה שממקסמת את התועלת הצפויה של תוצאות הפעולה - כלומר, מה שהסוכן מצפה להפיק, בממוצע, בהתחשב בהסתברויות והתועלת של כל תוצאה. סוכן המבוסס על כלי עזר צריך למדל ולעקוב אחר הסביבה שלו, משימות שכללו הרבה מחקר על תפיסה, ייצוג, חשיבה ולמידה.

סוכן לומד[עריכת קוד מקור | עריכה]

ללמידה יתרון בכך שהיא מאפשרת לסוכנים לפעול בתחילה בסביבות לא ידועות ולהיות מוכשרים יותר ממה שהידע הראשוני שלה לבדו עשוי לאפשר. ההבחנה החשובה ביותר היא בין "אלמנט הלמידה", שאחראי על ביצוע שיפורים, לבין "אלמנט הביצוע", האחראי על בחירת פעולות חיצוניות.

אלמנט הלמידה משתמש במשוב מה"מבקר" על מצבו של הסוכן וקובע כיצד יש לשנות את אלמנט הביצוע, או "השחקן", כך שיצליח בעתיד. אלמנט הביצוע הוא מה שהחשבנו בעבר כסוכן כולו: הוא קולט תפיסות ומחליט על פעולות.

המרכיב האחרון של סוכן הלמידה הוא "מחולל הבעיות". היא אחראית להציע פעולות שיובילו לחוויות חדשות ואינפורמטיביות.

הסיווג של וייס[עריכת קוד מקור | עריכה]

וייס (2013) הגדיר ארבע מחלקות סוכנים:

- סוכנים מבוססי היגיון - שבהם ההחלטה לגבי הפעולה לבצע מתבצעת באמצעות ניכוי לוגי;

- סוכנים ריאקטיביים - בהם קבלת החלטות מיושמת בצורה כלשהי של מיפוי ישיר ממצב לפעולה;

- סוכני "אמונה-רצון-כוונה" - שבהם קבלת החלטות תלויה במניפולציה של מבני נתונים המייצגים את האמונות, הרצונות והכוונות של הסוכן;

- ארכיטקטורות שכבות - שבהן קבלת ההחלטות מתבצעת באמצעות שכבות תוכנה שונות, שכל אחת מהן מנמקת פחות או יותר באופן מפורש לגבי הסביבה ברמות שונות של הפשטה.

סוכנים תבוניים זמינים לתפעול (נכון לאפריל 2023)[עריכת קוד מקור | עריכה]

מאז הופעתם של "מודלי השפה הגדולים", הנושא מאוד התפתח. הופעת היכולת לייצר "בוט שיחה" גרמה לזה שניתן לתפעל סוכנים תבוניים - על ידי חיבור בין ה"בוט שיחה" לבין יכולות שיטוט וביצוע פעולות באינטרנט - כולל הפעלת מנועי חיפוש ו/או הפעלת יישומים על בסיס API. במובנים רבים, "בוט השיחה" הופך להיות "מערכת הפעלה" שמאפשרת הפעלת יישומים רבים ושונים - בצורה עצמאית (אוטונומית) - כאשר "בוט השיחה" עושה את הפונקציות שלהלן:

- 1. הבוט "מבין" מה המשתמש רוצה - באמצעות "מודל שפה גדול".

- 2. הבוט הופך את ההבנה הזו - לקבוצה של פונקציות מטרה מוגדרות היטב.

- 3. הבוט יודע לתעדף בין פונקציות המטרה.

- 4. הבוט יודע לממש את פונקציית המטרה (להוציא אותה לפועל, באמצעות הגדרת משימות ברורות והפיכתן ל"סט" פעולות מוגדרות היטב).

- 5. הבוט, בהסתמך על מודל השפה הגדול - יודע לשמור על ההקשר של כלל פעולותיו, כולל רישום לזיכרון קצר טווח, זיכרון ארוך טווח וזיכרון במבנה המאפשר אחזור לפי הקשר או לפי אירועים או לפי זמן.

- 6. הבוט יודע ליצור ולהפעיל "בוטים משניים" ולהקצות להם משימות.

- 7. הבוט יודע לגשת לקבצים שהוא עצמו פתח - ולעשות עליהם את מגוון הפעולות ש"מודל השפה הגדול" יכול לעשות - כמו למשל תמצות, עריכה לשונית, תרגום וכיוצא באלו.

- 8. הבוט יודע "לארוז" את כלל התוצרים לפורמט הרצוי למשתמש - כמו למשל מאמר, בלוג, פוסט בלינקדאין או פייסבוק וכיוצא באלו.

- 9. מכיוון שהממשקים בין ה"בוט" לאינטרנט כרוכים בגישה לאתרי אינטרנט, פלטפורמות חברתיות וכיוצא באלו - פעמים רבות, או שהגישה נחסמת בפני ה"בוט" או שמדובר בשפה אחרת או שפעולת ה"בוט" נכשלת בהבנת פורמט הממשקים וכיוצא באלו. ה"בוט" - יודע להבין שזה קרה, לפתח לעצמו דרכים חלופיות להשגת המשימות/ פונקציית המטרה וחוזר חלילה, בלי שנדרשת מעורבות אדם.

ככל הידוע, אין מניעה שהבוט יפעל "אל מול בני אדם", למשל, על ידי כתיבת "פוסטים" או דואר אלקטרוני ואין גם מניעה ש"סוכן תבוני" כזה ינסה להשיג את פונקציית המטרה שלו על ידי ביצוע מניפולציות על בני אדם - כדי להניע אותם "לפעול עבורו".

דוגמאות לסוכנים תבוניים שהודגמו בפועל[עריכת קוד מקור | עריכה]

נכון לאפריל 2023, רוב הסוכנים התבוניים נשענים על ה"בוט" ChatGPT של חברת OpenAI, בגרסה שנשענת על מודל השפה הגדול GPT-4. מודל שזכה לפופולריות בקרב המשתמשים הוא מודל Auto-GPT.[16] מודל זה מאפשר את כל הפונקציות שהוזכרו למעלה.

אחת הדוגמאות היותר מפורסמות היא מימוש של המודל שנקרא Chaos - GPT, למודל זה הוגדרה פונקציית מטרה של השמדת האנושות והפיכתו שלו - לישות נצחית. המודל, בצורה עצמאית לגמרי, החליט שהדרך לעשות את זה היא באמצעות נשק גרעיני, הוא אוסף מידע על סוגים שונים של נשק כזה ומתכנן איך לבצע את המהלך - כולל עדכון שוטף של הציבור באמצעות הודעות "טוויטר".[17]

סוכן תבוני יותר נוח לשימוש, הוא אתר האינטרנט: Agent - GPT

מכיוון שאתרים אלה נשענים על מפתח ההצפנה של המשתמש באפליקציית OpenAI והם יוכלים "לרוץ" ללא מגבלת זמן - המשתמש עלול לגלות שעלות ההפעלה גבוהה בהרבה ממה שהוא תכנן - והשפעות הסוכן התבוני עלולות "להתבדר". בהתאם, לא מומלץ להפעיל סוכנים כאלה ללא מגבלת כמות פעולות או זמן

סוג סוכן נוסף פופולארי הוא babyAGI.

כמוכן, קיימים סוכנים למשימות נקודתיות כמו GPTEngineer ו- MetaGPT.

קישורים חיצוניים[עריכת קוד מקור | עריכה]

הערות שוליים[עריכת קוד מקור | עריכה]

- ^ 1 2 Russell & Norvig 2003, chpt. 2.

- ^ Bringsjord, Selmer and Govindarajulu, Naveen Sundar, "Artificial Intelligence", The Stanford Encyclopedia of Philosophy (Summer 2020 Edition), Edward N. Zalta (ed.), URL = https://plato.stanford.edu/archives/sum2020/entries/artificial-intelligence/.

- ^ Wolchover, Natalie (30 בינואר 2020). "Artificial Intelligence Will Do What We Ask. That's a Problem". Quanta Magazine (באנגלית). נבדק ב-21 ביוני 2020.

{{cite news}}: (עזרה) - ^ Bull, Larry. "On model-based evolutionary computation." Soft Computing 3, no. 2 (1999): 76-82.

- ^ Russell & Norvig 2003, pp. 4–5, 32, 35, 36 and 56.

- ^ 1 2 3 Bringsjord, Selmer and Govindarajulu, Naveen Sundar, "Artificial Intelligence", The Stanford Encyclopedia of Philosophy (Summer 2020 Edition), Edward N. Zalta (ed.), forthcoming URL = <https://plato.stanford.edu/archives/sum2020/entries/artificial-intelligence/>.

- ^ Kaplan, Andreas; Haenlein, Michael (1 בינואר 2019). "Siri, Siri, in my hand: Who's the fairest in the land? On the interpretations, illustrations, and implications of artificial intelligence". Business Horizons. 62 (1): 15–25. doi:10.1016/j.bushor.2018.08.004.

{{cite journal}}: (עזרה) - ^ Lin Padgham and Michael Winikoff. Developing intelligent agent systems: A practical guide. Vol. 13. John Wiley & Sons, 2005.

- ^ Russell & Norvig 2003, p. 27.

- ^ Domingos 2015, Chapter 5.

- ^ Domingos 2015, Chapter 7.

- ^ Lindenbaum, M., Markovitch, S., & Rusakov, D. (2004). Selective sampling for nearest neighbor classifiers. Machine learning, 54(2), 125–152.

- ^ "Generative adversarial networks: What GANs are and how they've evolved". VentureBeat. 26 בדצמבר 2019. נבדק ב-18 ביוני 2020.

{{cite news}}: (עזרה) - ^ Russell & Norvig 2003, pp. 46–54

- ^ Stefano Albrecht and Peter Stone (2018). Autonomous Agents Modelling Other Agents: A Comprehensive Survey and Open Problems. Artificial Intelligence, Vol. 258, pp. 66-95. https://doi.org/10.1016/j.artint.2018.01.002

- ^ כתבה באתר Digitaltrends

- ^ כתבה באתר Decrypt